Bonjour !

Voici donc l'avant-dernière étape de notre projet pour ce semestre (la dernière étant la création du site web) : l'utilisation du logiciel Le Trameur. Pour cela, nous avons besoin des fichiers Contextes Globaux.

Le trameur est un outil à la croisée des statistiques et de la linguistique. Il a été développé notamment par M. Serge FLEURY (laboratoire CLA²T/SYLED). Cet outil permet le calcul des cooccurrents dans un texte donné.

Les deux notions fondamentales du Trameur sont la trame et le cadre. La trame correspond au découpage en unités et le cadre au partitionnement du texte. Le Trameur va donc travailler sur un vecteur de positions d'unités dans le texte. On va pouvoir agréger des annotations sur chaque unité segmentée. Il n'y a aucune restriction dans le nombre d'annotations greffées sur les unités segmentées.

Il existe deux moyens d'entrer dans le logiciel :

- lui donner un texte que l'on a construit = création d'une nouvelle base

- importer une base textométrique existante qui contient une trame et un cadre avec une ribambelle d'annotations (micro et macro-syntaxe, prosodie...)

La carte des sections est un outil textométrique permettant de donner une représentation graphique d'un texte sous forme de sections. Sur cette représentation, nous voyons une succession de petits carrés qui correspondent chacun à une section précise du texte. En passant la souris sur chaque carré, on voit le contenu de la section.

Dans le Trameur, tous les calculs peuvent être faits sur n'importe quel niveau d'annotation.

La carte des sections est un bon outil pour rendre compte de l'alignement (ex : traduction, etc.).

Le résultat du calcul des cooccurrents pour un pôle est donné sous forme de réseau. La couleur de l'arc traduit le degré d'attraction entre le candidat cooccurrent et le pôle choisi. L'épaisseur de l'arc traduit le nombre de contextes communs entre le pôle et son candidat. Le label de l'arc indique la fréquence, la spécificité et le nombre de contextes.

Voici nos résultats en images (les couleurs et les labels ne sont malheureusement pas très visibles) :

.png) |

| Réseau de cooccurrents pour l'anglais |

.png) |

| Réseau de cooccurrents pour l'espagnol |

.png) |

| Réseau de cooccurrents pour le français |

.png) |

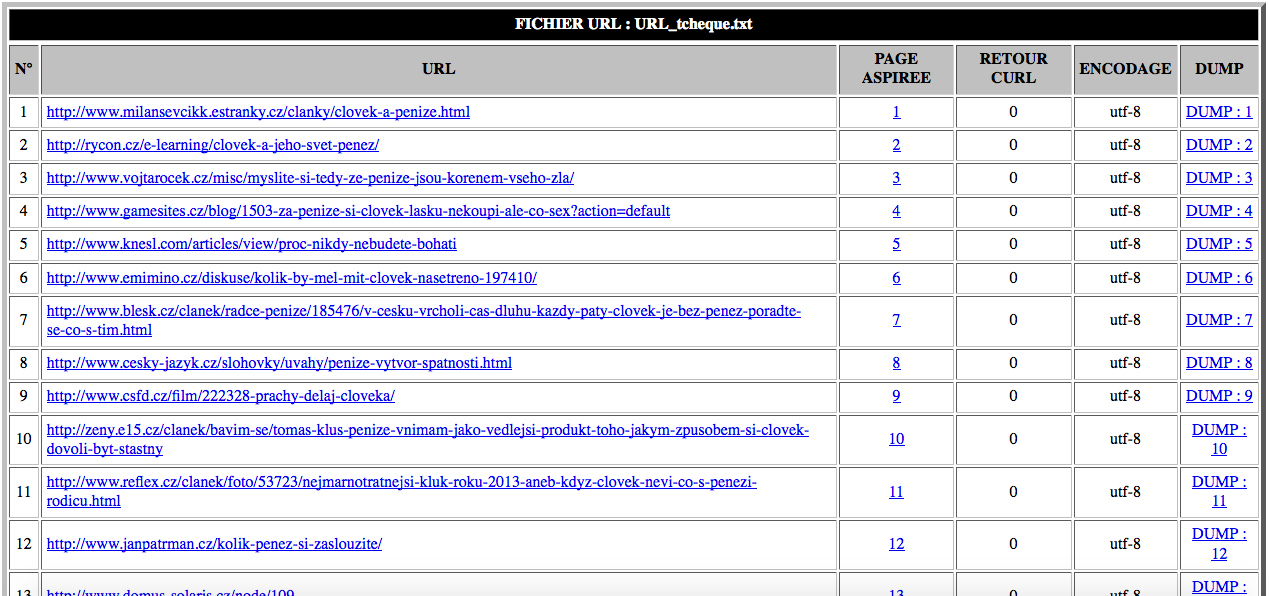

| Réseau de cooccurrents pour le tchèque |

Et voilà, c'est terminé pour cette fois ! Il ne nous reste plus qu'à donner les dernières touches à notre site web pour que le projet soit vraiment fini...

A bientôt !

.png)

.png)

.png)